Analitycy danych muszą być w stanie analizować, wizualizować i przekształcać ogromne zbiory danych w spostrzeżenia. Jednak rozwiązania skalowalne w poziomie często ugrzęzły w zbiorach danych rozproszonych na wielu serwerach.

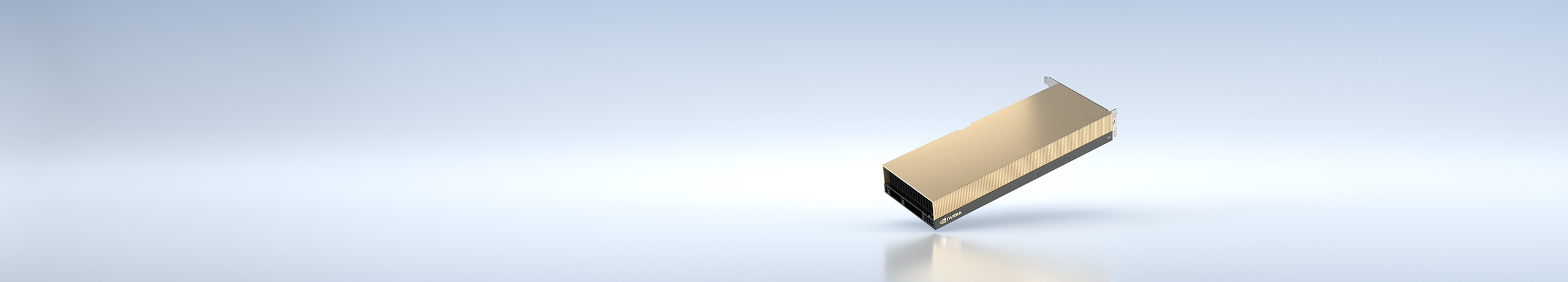

Przyspieszone serwery z A30 zapewniają potrzebną moc obliczeniową — wraz z dużą pamięcią HBM2, przepustowością pamięci 933 GB/s i skalowalnością za pomocą NVLink — aby sprostać tym obciążeniom. W połączeniu z NVIDIA InfiniBand, NVIDIA Magnum IO i pakietem bibliotek open source RAPIDS™, w tym RAPIDS Accelerator dla Apache Spark, platforma centrum danych NVIDIA przyspiesza te ogromne obciążenia z niespotykanym dotąd poziomem wydajności i efektywności.